NVIDIA 的杀器级新技术已经悄然推出了

前几日,NVIDIA 悄悄推出了一版全新的显卡驱动 —— 445.75,在这一版本显卡驱动里,NVIDIA 首次加入了他们最新的技术,根据官网对这项功能的描述以及各种在游戏里的实际测试。

对于现有的 NVIDIA RTX 显卡来说,相较于这项技术的前身,它将给玩家的游戏体验带来一个质的飞跃,对于 NVIDIA 直接竞争对手 AMD,以及微软、索尼这两家和 AMD 建立了亲密合作的主机厂商来说。

这项技术如果能在游戏行业得到广泛运用,它非常有可能在一定程度上改变整个行业的一些规则,甚至可能会直接提升 PC 在整个行业内的地位。

毕竟这几代主机都已经投靠了 AMD,就算他们想要换用 NVIDIA 的 GPU,也基本上是要等到下一世代了,而在这之间,NVIDIA 还有很长的时间去对他们的架构进行新的迭代。

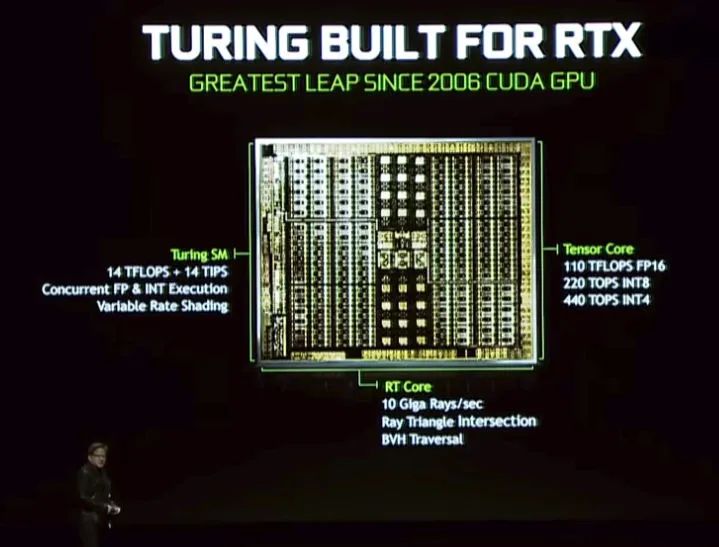

这项新技术是 DLSS 2.0,是此前 DLSS 技术的更新升级版。DLSS 这个技术是 NVIDIA 配合 RTX 系列显卡同步推出的,在使用 Turing 架构的这一代显卡中,除了用于处理实时光线追踪的 RT Core 外,他们还特别加入了用于处理 AI 计算的 Tensor Core。

RT Core 对应的技术是 NVIDIA 这一代显卡的王牌技术,他们甚至特别为此更改了系列名。从长远来看,实时光线追踪也确实是实时渲染这一方面的未来发展方向,它非常有利于在游戏内给玩家呈现一个更具真实感、更加精致且细腻的游戏世界。

在 RTX 系列显卡刚刚推出的时候,实时光线追踪是被媒体提起最多且关注最多的,直到现在实时光线追踪方面的消息也是频获媒体关注,相关的新闻一直都在传出。

而 Tensor Core 由于其本身并不直接对应某个强大的实时渲染技术,并不能很直接的在游戏这一领域给玩家带来体验的直线提升,所以在 RTX 系列显卡发售后,这一部分往往并不怎么被媒体重视。

对于这一部分特别的核心,NVIDIA 原本的想法是通过它来提升显卡在深度学习这一领域的运算性能,它是一部分针对 FP16、INT8、INT4 运算进行了深度优化的核心,在整个图灵架构的 GPU 里,它也占据了不小的一部分。

这一部分核心的存在使 Geforce 这种非专业卡也能够具有较强的深度学习计算能力,这使得这一部分显卡在游戏之外也能够具有更强大的生产力,能够被用于一些专业领域,譬如 AI 方面的研究以及各种图像、影视工作室等。

利用这一部分 Tensor Core,深度学习方面的训练速度能够得到明显的增强,而且在运行一些边缘计算的时候,其速度也能够得到显著的提。目前有很多专业软件都有在利用 AI 技术来强化其性能和功能,Tensor Core 在这方面能对这部分功能 / 软件起到至关重要的加速作用。

为了体现一下 Tensor Core 除了在专业领域外,对于玩家来说它也能起到一定程度的体验提升,在 RTX 系列显卡发布之后,NVIDIA 也是联合一些游戏厂商(数量并不多)上线了 DLSS 基础。

这项技术最初是被用于抗锯齿,在 DLSS 出现之前,抗锯齿技术主要有三种,分别是 FXAA、MSAA 和 TAA,其中 FXAA 属于在图像渲染管线的后期对图像进行优化处理的技术,它在着色器上通过取一个和 MSAA 相近的快速近似值,以消除图像的锯齿感。这种技术的优点主要在于速度快,相信很多有使用过低配电脑的玩家应该对这个有比较深刻的感触,用 FXAA 会比用 MSAA 快很多,但是对于图像质量来说,FXAA 往往会带来一种「发虚」的感觉。

MSAA、TAA 则是通过在渲染过程中预先进行超采样渲染,经过一系列算法来实现对锯齿的消除,相较于 FXAA 这种单纯进行后期处理的算法,这些抗锯齿方式相对而言很吃硬件资源,想要得到很好的抗锯齿效果,硬件的开销是很大的。

在 DLSS 之前,NVIDIA 曾经推出过 TXAA 来改良抗锯齿的效果,但是在深度学习大热的这几年,NVIDIA 也开始逐渐转变了思路,试图直接用一个 AI 来处理图像,解决图像的锯齿问题。

其好处在于,由于 DLSS 的模型是预先训练好的,对于玩家来说,玩家的显卡只需要运行一些 AI 方面的边缘计算对画面进行处理,就能够得到一个相当理想理想的效果。

根据 NVIDIA 的描述,初代的 DLSS 技术能够匹配高达 64 倍超采样的抗锯齿效果,让锯齿基本上感觉不到。然而,由于在发售后支持 DLSS 的游戏很少,而且 DLSS 和 FXAA 一样,它其实并没有做真正的超高倍率超采样,而是用

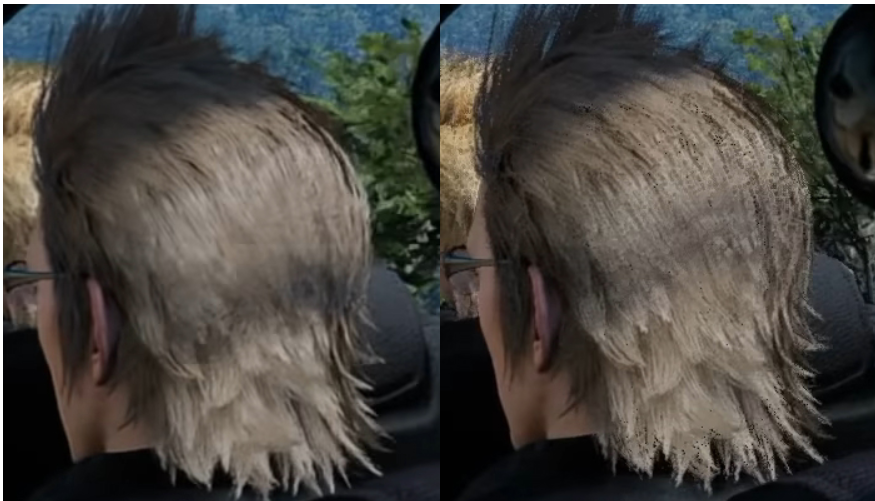

在这种「近似」的效果下,很多玩家对 DLSS 的评价都是画面比较模糊,没有 MSAA、TAA 这些传统的抗锯齿技术呈现的画面那么「锐利」。严格意义来说,即使是近似,只要它能较为精准地近似一个高倍率的超采样抗锯齿效果,原则上其画面也不会又很明显的锐度区别,这种模糊更多是 AI 带来的副作用。

其实就和手机上的 AI 功能一样,华为是用 AI 技术优化拍照用得最多的一家。如果你有自习对比华为手机和其他手机的图片,在经过了算法优化后,照片在细节上会有一些比较厚重的涂抹感。

实际上 AI 归根结底还是死板的,它是根据大量训练得到的一套规则去处理图像。对于 AI 模型,这种内部的规则以及这种规则的触发机制如果要详细去解释分析可能需要花费相当长的时间,对于研究者来说这很可能是一个很深的地狱,但是对于应用来说,这种模型就宛如神仙一般的存在。

对于图片来说,消除锯齿做得不够精细确实容易把和锯齿比较近似的图像物体边缘一并给模糊掉,加上 DLSS 前代支持的游戏也不多,没有起到什么实质性的作用,网友对于 DLSS 的口碑一直都不太好。

在 DLSS 2.0 上,NVIDIA 是打算彻底洗掉 DLSS 的坏名声,让它和实时光线追踪一样成为一个划时代的技术。

DLSS 2.0 走了一个非常激进的路线,DLSS 虽然是一种优化方法,但是它还是以用户设置的分辨率位基础渲染画面,在这之上去尽可能逼近一个超高倍率超采样抗锯齿的效果,以尽可能提升画面质量。

而 DLSS 2.0 则更多侧重于性能,试图利用 AI 技术来让玩家的游戏体验得到一个质变。既然 AI 能够实现对超高倍率超采样抗锯齿的逼近,那么它其实同样也可以实现低分辨率画面向高分辨率画面的逼近,同时这种逼近也是可以自带抗锯齿效果的。

毕竟 AI 的逻辑就是给定某一种输入,让它去尽可能得到某一种输出,如果我们提前把这种输出就定为一个分辨率更高的、经过高倍率超采样抗锯齿的画面,那么通过大量的训练和参数上的调校,AI 就有可能从中学习到一套规律,把我们输入的低分辨率画面转化成我们想要的结果。

出于这样一个概念,DLSS 2.0 采用了和 DLSS 不同的全新模型,它能够让游戏的画面以一个更低的分辨率渲染,以减少显卡的工作负荷,通过在渲染管线后期利用这样的技术强行对低分辨率画面进行升采样,使其尽可能在观感上达到一个和高分辨率画面十分近似的感觉。

对于 RTX 系列显卡来说,在很多作品里如果开启了光线追踪,整个画面的帧率会因此降低很多,因为实时光线追踪的计算量很大。但是对于渲染这件事情,我们都知道,只要降低了渲染的分辨率,那么显卡的总工作量就会有一个非常大的下降。

在 DLSS 2.0 下,NVIDIA 通过他们精湛的技术,让一个原本是 1080p 下的游戏画面以 720p 的分辨率渲染,然后通过 AI 升采样到 1080p,同时保证画面的锐度,使其看起来不模糊。

细节上,DLSS 2.0 处理出来的画面和原生的 1080p 画面十分相似,甚至有的时候 DLSS 2.0 的画面在细节上会更强一些,可以说是相当玄学。在画面质量差异不大的情况下,通过降低图像的渲染分辨率,玩家得到的帧速率能够有一个惊人的提升。

这其实等同于我们在用 720p 玩游戏,但是我们的观感是 1080p 的。在 NVIDIA 官方给出的例子中,很多游戏在利用 DLSS 2.0 进行处理后能够得到相当显著的性能提升,同时画面的质量仍然能够得到比较好的保证。

对于想要用 4K 分辨率来玩游戏的玩家来说,他们能够通过 DLSS 2.0 获得极为明显的流畅度提升,帧率甚至能够向上提升一倍。在这种流畅度的巨大提升下,相信没有多少玩家能够扛得住 DLSS 2.0 的诱惑。

如果笔者正在玩的游戏支持 DLSS 2.0,且显卡刚好也支持这一特性,那么笔者肯定会把它打开以获取更强的性能表现。毕竟游戏里面很多场景其实也是高度动态的,尤其是各种第一人称的游戏,细节相对而言其实不是那么重要,而性能对于游戏体验的影响相较而言要明显不少。

和初代 DLSS 一样,DLSS 2.0 也需要游戏厂商和 NVIDIA 合作做专门的适配,可能是因为 AI 模型需要针对化的训练,得到一份配置文件。

对于 DLSS 2.0,笔者对其未来可以说是相当看好,通过基本上不怎么损失的画面换取巨大的性能提升,相信所有的玩家都是愿意选择接受的,特别是在现在 3A 大作画面越来越绚丽、越来越复杂,哪怕是顶级卡跑起来都不见得很流畅的情况下,DLSS 2.0 真的是一个相当大的进步。

不知道未来会有多少游戏能够添加这项技术的支持,在笔者看来如果它能够得到育碧、EA 等厂商的支持,那么它在未来对整个游戏行业的影响是比较大的。值得一提的是,在现有的驱动里,NVIDIA 已经加入了对 UE4 在 DLSS 2.0 这方面的支持,如果你是一位虚幻引擎开发者,那么你可以亲自体验一下这项技术的强大能力。

技宅空格

技宅空格